Введение

В технической оптимизации SEO особое внимание уделяется конфигурации файлов robots.txt и sitemap.xml. Эти файлы играют ключевую роль в управлении взаимодействием поисковых систем с вашим сайтом, помогая эффективно индексировать и ранжировать страницы.

1. Что такое файл robots.txt?

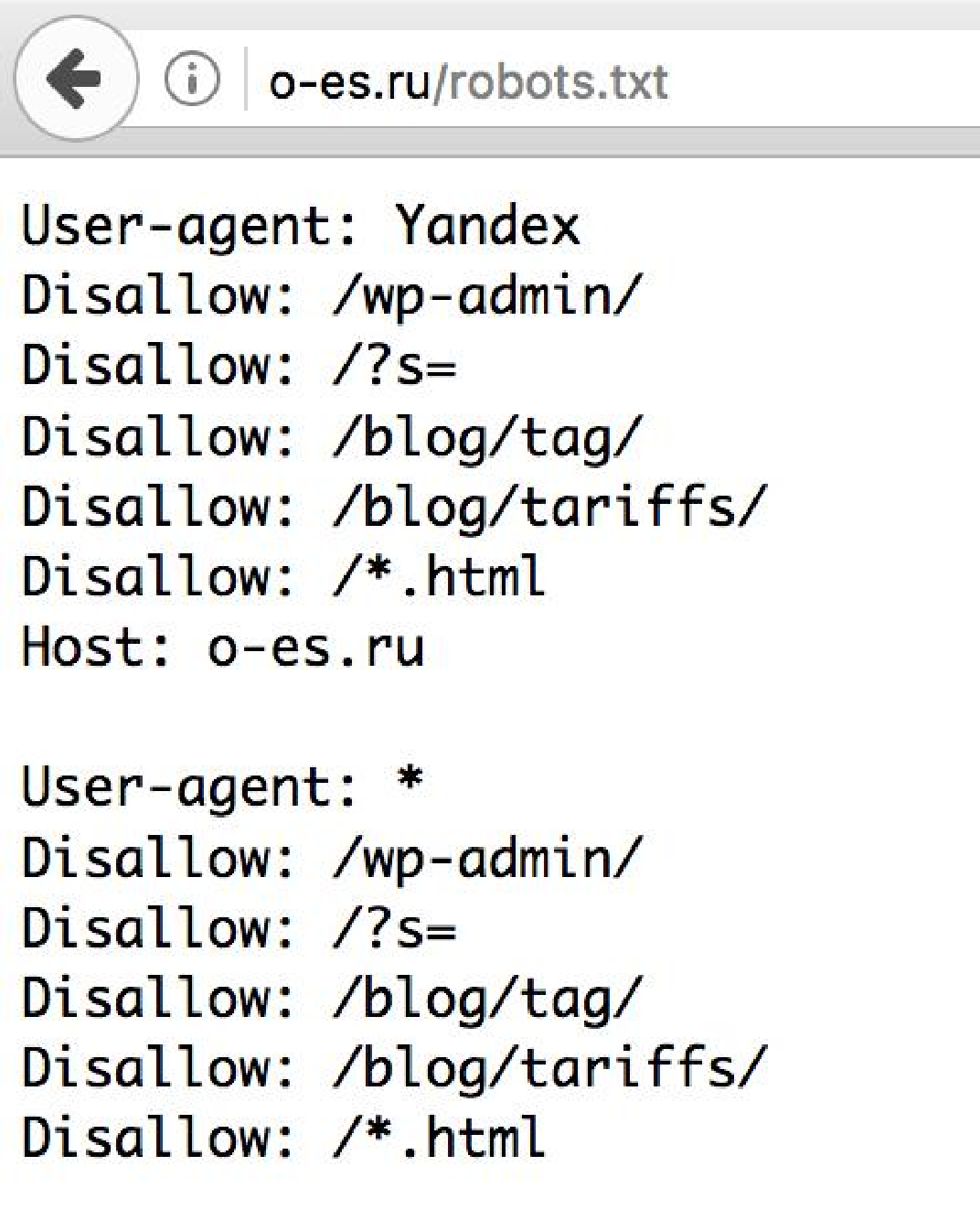

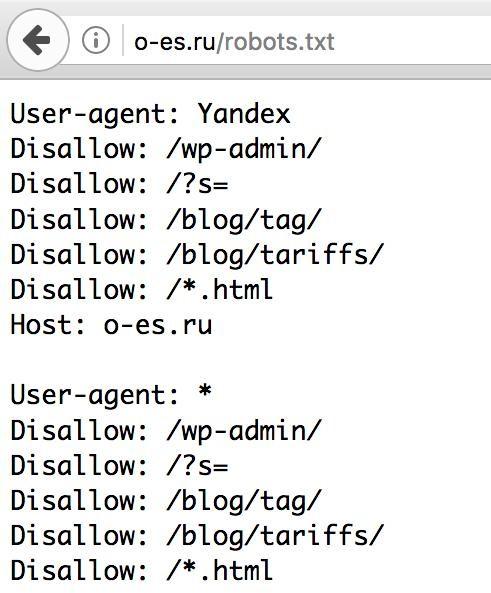

Файл robots.txt — это текстовый файл, размещенный в корневом каталоге вашего веб-сайта, который дает указания поисковым роботам о том, какие страницы или разделы сайта они могут или не могут сканировать. Этот файл используется для управления краулингом и предотвращения индексации определенного контента.

Основные директивы:

● User-agent: Определяет, к какому поисковому роботу применяется правило. Символ * означает, что правило применяется ко всем роботам.

● Disallow: Запрещает сканирование указанных страниц или каталогов.

● Allow: Разрешает сканирование указанных страниц или каталогов (чаще используется в сочетании с

Disallow).

Практические советы:

● Не блокируйте страницы, которые вы хотите видеть в поисковой выдаче.

● Используйте robots.txt для блокировки дублированного контента, страниц с личными данными или технических страниц.

2. Создание и настройка файла robots.txt

1. Создание файла: Создайте текстовый файл с именем robots.txt.

2. Размещение файла: Разместите файл в корневом каталоге вашего сайта (например,

https://www.yourwebsite.com/robots.txt).

3. Редактирование файла: Откройте файл в текстовом редакторе и добавьте необходимые директивы.

3. Проверка файла robots.txt

После создания и размещения файла, проверьте его корректность с помощью инструмента проверки файла robots.txt в Google Search Console. Это поможет убедиться, что ваши правила правильно интерпретируются поисковыми системами.

4. Что такое файл sitemap.xml?

Файл sitemap.xml — это XML-документ, который содержит список всех страниц вашего сайта, которые должны быть проиндексированы поисковыми системами. Этот файл помогает поисковым роботам быстрее и эффективнее находить и индексировать контент вашего сайта.

Основные элементы:

● <urlset>: Корневой элемент, содержащий набор URL-адресов.

● <url>: Элемент, описывающий отдельную страницу.

● <loc>: URL страницы.

● <lastmod>: Дата последнего изменения страницы.

● <changefreq>: Частота изменения страницы (например, daily, monthly).

● <priority>: Приоритет страницы относительно других страниц сайта (от 0.0 до 1.0).

5. Создание и настройка файла sitemap.xml

1. Создание файла: Используйте генераторы карт сайта (например, Screaming Frog, Yoast SEO) или создайте файл вручную.

2. Размещение файла: Разместите файл в корневом каталоге вашего сайта (например,

https://www.yourwebsite.com/sitemap.xml).

3. Уведомление поисковых систем: Добавьте URL-адрес вашей карты сайта в Google Search Console и другие инструменты для веб-мастеров.

6. Проверка и обновление файла sitemap.xml

Регулярно проверяйте и обновляйте файл sitemap.xml, чтобы он всегда содержал актуальную информацию о структуре вашего сайта. Используйте инструменты проверки карт сайта в Google Search Console для выявления и исправления ошибок.

Заключение

Файлы robots.txt и sitemap.xml являются важными инструментами технической SEO-оптимизации. Правильная настройка и управление этими файлами помогает поисковым системам эффективно сканировать и индексировать ваш сайт, улучшая его видимость и ранжирование в поисковой выдаче.